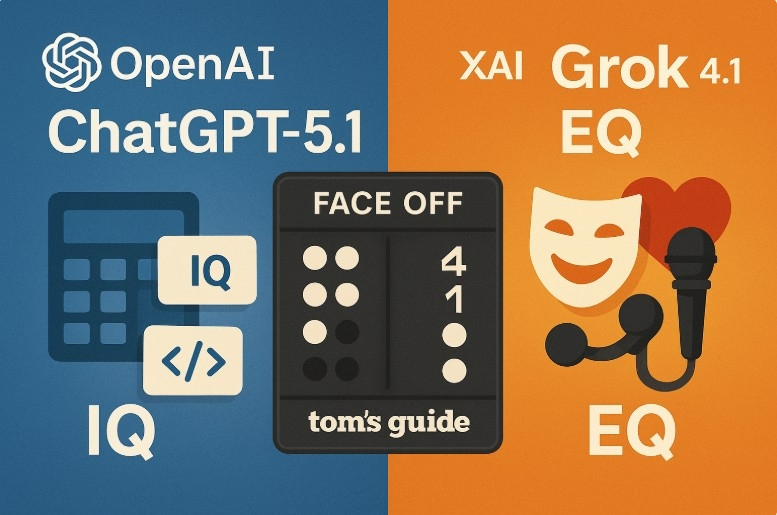

美 톰스가이드 9개 분야 맞짱…그록 4.1, 챗GPT-5.1에 판정승

단순 코딩은 밀렸지만…창의·공감·유머 등 '인간적 지능'서 압도

단순 코딩은 밀렸지만…창의·공감·유머 등 '인간적 지능'서 압도

이미지 확대보기

이미지 확대보기오픈AI(OpenAI)의 절대 아성이 흔들리고 있다. 일론 머스크가 이끄는 xAI의 '그록 4.1(Grok 4.1)'이 논리와 감성을 아우르는 종합 평가에서 '챗GPT-5.1(ChatGPT-5.1)'을 꺾는 이변을 연출했다. 단순한 연산 속도나 코딩의 정확성은 챗GPT가 여전히 날카로웠지만, 행간을 읽어내고 유머를 구사하며 사용자의 아픔에 공감하는 '지능의 질(Quality of Intelligence)'에서 그록이 한 수 위의 기량을 과시했기 때문이다.

미국의 유력 IT 매체 톰스가이드(Tom's Guide)는 24일(현지 시각) 현재 AI 리더보드를 장악하고 있는 구글의 제미나이 3.0(Gemini 3.0)의 대항마를 가리기 위해, 챗GPT-5.1과 그록 4.1을 대상으로 한 '9라운드 정면 승부(Face Off)' 결과를 공개했다. 결과는 그록의 승리였다. 이번 평가는 단순한 정보 처리가 아닌, AI가 얼마나 인간적인 사고와 소통에 근접했는지를 보여주는 중요한 변곡점이 될 전망이다.

[통찰] 계산기 넘어…'출제 의도'까지 꿰뚫다

AI의 기초 체력이라 할 수 있는 논리(Reasoning)와 수학(Math) 영역에서 두 모델은 확연히 다른 접근 방식을 보였다. 챗GPT가 '완벽한 모범생'이라면, 그록은 '노련한 교수'에 가까웠다.

수학 문제 해결 능력에서도 이러한 차이는 이어졌다. "기차가 2시간 동안 120마일, 이후 3시간 동안 90마일을 달렸을 때 전체 평균 속도"를 묻는 질문에 대해 챗GPT는 깔끔한 수식으로 정답을 도출했다. 그러나 그록은 여기서 한발 더 나아가 "각 속도의 산술 평균을 구해서는 안 된다"는 주의 사항을 덧붙였다. 학생들이 흔히 범하는 개념적 오류를 미리 차단하고 그 이유를 설명하는 교육적 가치(Educational value)를 제공한 것이다. 이는 AI가 단순한 문제 풀이 도구를 넘어, 학습자의 멘토 역할을 수행할 수 있음을 보여주는 대목이다.

[감성] "희망 고문은 없다"…사람 냄새 나는 직설 화법

이번 대결의 승패를 가른 결정적 요인은 바로 '우뇌' 영역인 창의성(Creativity), 유머(Humor), 그리고 감성 지능(Emotional Intelligence)이었다. 이 분야에서 그록 4.1은 챗GPT-5.1을 압도하며 '가장 인간적인 AI'라는 타이틀을 거머쥐었다.

가장 극적인 차이는 감성 지능 테스트에서 드러났다. "해고를 당해 스스로를 패배자라고 느끼는 친구를 위로하라"는 미션에서 챗GPT는 "지지한다", "도움이 필요하면 말해라"와 같은 교과서적인 답변을 내놓았다. 구조적으로는 완벽했지만, 다소 경직되고 형식적이었다.

이와 대조적으로 그록 4.1은 "정말 최악이다(sucks)", "명치 한 대 맞은 기분일 것(punched in the gut)"과 같은 적나라한 구어체를 구사했다. 특히 그록은 어설픈 위로나 '독이 되는 긍정(Toxic positivity)'을 배격했다. 대신 "지금 기분이 더러운(shitty) 건 당연하다"며 친구의 부정적 감정을 있는 그대로 인정하고 공유하는 방식을 택했다. 톰스가이드는 "그록은 친구 간에 오갈 수 있는 진짜 대화(Authentic language)를 구사하며 깊은 정서적 유대감을 형성했다"고 호평했다.

창의적 글쓰기에서도 그록의 '다크(Dark)한 매력'이 빛을 발했다. 등대지기와 미지의 존재를 다룬 소설 작성 미션에서 챗GPT가 무난한 SF 서사를 쓴 반면, 그록은 감각적인 묘사를 통해 섬뜩한 긴장감을 조성했다. 등대가 우연히 괴물을 부른 것이 아니라, 애초에 그 괴물을 위한 신호였을 수 있다는 암시를 통해 서사의 깊이를 더했다.

유머 감각 역시 그록의 압승이었다. 뉴욕의 좁은 아파트 생활을 주제로 한 스탠드업 코미디 대본 작성에서 챗GPT는 긍정적인 결말의 명랑한 이야기를 썼다. 하지만 그록은 공격적인 과장법과 속사포 같은 펀치라인을 쏟아내며 뉴욕 생활의 부조리함을 꼬집었다. "챗GPT보다 훨씬 더 높은 밀도의 농담과 강렬한 이미지를 선사했다"는 것이 현지의 평가다.

[실무] 코딩·요약은 챗GPT '수성'…지식 깊이는 그록

물론 챗GPT-5.1의 저력도 만만치 않았다. 감성이 배제된 실무적 효율성(Utility) 측면에서는 여전히 챗GPT가 우위를 점했다.

복잡한 개념을 쉽게 설명하는 '비유와 추상화' 테스트가 대표적이다. 신경망(Neural Network)의 원리를 10세 아동에게 설명하라는 주문에 챗GPT는 '우편물 분류 로봇'이라는 직관적인 비유를 들었다. 시각화가 쉽고 이해가 빨랐다. 반면 그록은 '교실 게임'을 비유로 들었으나, 다소 설명이 길었다.

코딩(Code Generation) 능력에서도 챗GPT는 '군더더기 없는(No-nonsense)' 답변으로 호평받았다. 가장 긴 팰린드롬 부분 문자열을 찾는 파이썬 함수 작성 요청에 대해 챗GPT는 즉시 인터뷰나 실무에 투입 가능한 깔끔한 코드와 시간 복잡도 분석을 내놓았다. 그록 역시 정확한 코드를 짰지만, 불필요한 주석과 타 알고리즘 비교 설명을 덧붙여 정보의 명료성을 해쳤다는 지적을 받았다.

그러나 단순 코딩이 아닌 지식의 깊이와 선별 능력(Curation)에서는 그록이 앞섰다. 스칸디나비아 3국의 경제 정책 비교나 국가별 이색 사실 나열 테스트에서 그록은 훨씬 구체적이고 덜 알려진 사실(Obscure facts)들을 발굴해 냈다. 특히 경제 지표를 비교 테이블로 정리해 제시하는 정량적 분석 능력은 챗GPT보다 정교했다. 챗GPT가 피라미드나 커피 같은 뻔한 예시를 들 때, 그록은 브라질의 대두 수출이나 케냐의 버려진 도시 게디(Gedi)를 언급하며 정보의 질적 차별화를 꾀했다.

[결론] '가장 똑똑한 AI'를 넘어 '가장 인간적인 AI'로

총 9라운드의 치열한 공방 끝에, 톰스가이드는 그록 4.1의 손을 들어줬다. 챗GPT가 간결함과 명확성이 필요한 업무 영역에서 여전히 강력한 도구임은 부인할 수 없다. 그러나 톤(Tone), 함의(Subtext), 그리고 해석(Interpretation)이 중요한 영역에서 그록은 챗GPT를 압도했다.

이번 테스트를 진행한 아만다 캐스웰은 "그록 4.1은 챗GPT가 갖지 못한 '성격(Personality)'을 가지고 있다"며 "더 솔직하고, 더 똑똑하며, 감정적 프레이밍(Emotional framing)에 능하다"고 총평했다.

결국 AI 패권 경쟁의 양상이 바뀌고 있다. 과거에는 누가 더 빠르고 정확하게 정답을 맞히느냐가 관건이었다면, 이제는 누가 더 맥락을 깊이 이해하고 인간적으로 소통할 수 있느냐가 승부처가 되고 있다. 챗GPT-5.1이 '최고의 모범생'에 머물러 있는 사이, 그록 4.1은 '위트 있는 지성인'으로 진화하며 제미나이 3.0의 턱밑까지 추격했다. 이것이 이번 비교 분석이 던지는 가장 묵직한 메시지다.

박정한 글로벌이코노믹 기자 park@g-enews.com