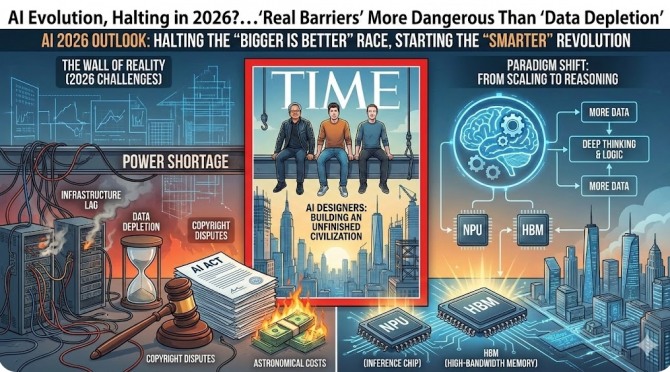

‘타임’지 선정 젠슨 황 등 AI 설계자들, ‘미완의 문명’ 건설 중

무조건적 덩치 키우기 ‘스케일링 법칙’ 한계…비용·규제 ‘이중고’

2026년 반도체 시장, ‘초거대 학습용’에서 ‘고효율 추론용’으로 무게중심 이동

무조건적 덩치 키우기 ‘스케일링 법칙’ 한계…비용·규제 ‘이중고’

2026년 반도체 시장, ‘초거대 학습용’에서 ‘고효율 추론용’으로 무게중심 이동

이미지 확대보기

이미지 확대보기지난 11일 미국 시사주간지 타임(TIME)이 젠슨 황 엔비디아 최고경영자(CEO) 등을 ‘올해의 인물’로 선정하며 AI 시대를 예찬했지만, 이면에서는 전력 부족과 데이터 고갈이라는 실질 장벽이 AI 진화 속도를 늦출 수 있다는 경고가 나왔다. 이에 따라 업계에서는 무작정 AI 모델의 크기를 키우는 경쟁을 멈추고, ‘깊은 사고’를 가능케 하는 추론 기술로 기술 패러다임을 전환하려는 움직임이 뚜렷하다.

일본 IT 전문매체 SBBIT는 최근 ‘AI 2026년 문제’를 심층 보도하며, 2026년이 AI 발전의 중대한 분기점이 될 것이라고 분석했다.

멈춰 선 건설 현장?…전력망과 규제가 발목 잡는다

타임지 표지에는 맨해튼 상공의 철제 빔 위에 위태롭게 앉아 있는 빅테크 CEO들의 모습이 묘사됐다. 이는 AI가 완성된 기술이 아니라 여전히 ‘공사 중인 문명’임을 상징한다. 문제는 이 거대한 구조물을 지탱할 현실 기반이 턱없이 부족하다는 점이다.

전문가들은 2026년을 기점으로 AI 데이터센터의 전력 소비량이 국가 단위의 전력망 용량을 위협하는 위험 수위에 이를 것으로 내다봤다. 젠슨 황 CEO와 샘 알트먼 오픈AI CEO가 최근 원자력 발전소 건설과 전력망 현대화를 논의 테이블에 올린 것도 이 때문이다. 하지만 소프트웨어의 발전 속도는 빛의 속도인 반면, 발전소 건설과 같은 물리적 인프라 확충에는 수년에서 수십 년이 걸린다. 이러한 ‘속도 불일치’가 2026년 AI 고도화를 가로막는 가장 큰 물리적 제약이 될 것이라는 분석이다.

규제 환경 또한 2026년부터 실질적인 강제력을 발휘한다. 유럽연합(EU)의 ‘AI 법(AI Act)’이 본격 시행되면서, 기업들은 기술을 개발해 놓고도 안전성 평가와 저작권 문제 해결을 위해 출시를 무기한 미뤄야 하는 상황에 직면할 수 있다. 특히 저작권 분쟁은 단순 배상금 문제를 넘어, 이미 학습시킨 데이터 자체를 삭제하거나 모델을 폐기해야 하는 리스크로 번지고 있어 기업들의 부담을 가중하고 있다.

‘스케일링 법칙’의 퇴조…이제는 ‘생각하는 AI’의 시간

실리콘밸리 안팎에서는 그동안 AI 성능 향상의 불문율로 통했던 ‘스케일링 법칙(Scaling Laws)’이 한계에 봉착했다는 목소리가 높다. 데이터와 연산량을 무한정 늘려도 성능 향상 폭이 비용 증가분을 따라가지 못하는 ‘수확 체감’ 현상이 나타나기 시작했기 때문이다. 인터넷상의 고품질 텍스트 데이터가 고갈되면서, 더는 ‘양적 투입’만으로는 획기적인 발전을 기대하기 어렵다는 지적이다.

이에 따라 2026년 기술 경쟁의 축은 ‘학습(Training)’에서 ‘추론(Inference)’으로 급격히 이동할 것으로 보인다. ‘추론형 AI’는 엄청난 데이터를 벼락치기로 암기하는 방식이 아니라, 주어진 문제에 대해 인간처럼 논리적으로 사고하고 검증하는 과정을 거친다.

반도체 시장, ‘HBM·추론 칩’ 수요 폭발…새로운 기회 온다

AI 기술의 중심축이 학습에서 추론으로 이동하면서 반도체 시장 지형도 또한 요동칠 것으로 보인다. 2025년까지는 거대 언어 모델(LLM)을 학습시키기 위한 엔비디아의 고성능 GPU(그래픽처리장치) 확보 전쟁이었다면, 2026년부터는 ‘추론 시장’을 겨냥한 고효율 반도체 수요가 폭증할 전망이다.

첫째, 고대역폭메모리(HBM)의 중요성은 더욱 커진다. 추론형 AI가 복잡한 논리 과정을 수행하려면 연산 장치가 데이터를 빠르게 주고받아야 한다. 특히 AI가 사고하는 동안 방대한 데이터를 임시 저장하고 처리할 메모리 대역폭이 필수적이므로, 삼성전자와 SK하이닉스가 주도하는 HBM 시장의 호황은 지속될 것으로 보인다.

둘째, 주문형 반도체(ASIC)와 신경망처리장치(NPU) 시장이 개화한다. 학습 단계에서는 범용성이 높은 GPU가 유리하지만, 이미 만들어진 모델을 서비스하는 추론 단계에서는 전력 소모를 줄이고 처리 속도를 높이는 ‘전용 칩’이 훨씬 경제적이다. 이에 따라 구글, 아마존 등 빅테크 기업들이 자체 개발한 추론용 칩 도입을 가속화할 것으로 보이며, 국내 팹리스(반도체 설계) 기업들에도 새로운 기회가 열릴 수 있다는 분석이 나온다.

AI의 진화가 멈추는 것이 아니라, ‘무식하게 큰 모델’에서 ‘똑똑하고 효율적인 모델’로 진화함에 따라 반도체 산업 또한 질적 성장을 요구받게 될 것이다.

박정한 글로벌이코노믹 기자 park@g-enews.com