이미지 확대보기

이미지 확대보기일본경제신문 닛케이에 따르면, 한국 SK하이닉스가 2013년 개발한 HBM은 여러 개의 D램 칩을 쌓아 데이터 처리 속도를 높이는 새로운 메모리 구조다. 대용량 데이터 처리가 필수적인 AI에 최적화된 임시 저장 메모리로 사용되고 있으며, SK하이닉스의 5세대 제품인 HBM3e의 경우 초당 처리 속도가 1.15테라(1테라=1조 바이트)에 달한다.

HBM 기술이 주목받는 이유는 기계학습형 AI의 확산에 따른 대용량 데이터 처리 수요 증가 때문이다. SK하이닉스는 AI 반도체의 강자인 미국 엔비디아와 협력하여 HBM 개발을 진행하고 있다.

엔비디아의 GPU는 대용량 데이터 처리에 탁월한 성능을 갖추고 있기 때문에, 보조 역할을 하는 D램에도 고속 대용량 처리 성능이 요구된다.

D램 시장에서 40%가 넘는 점유율을 차지하는 삼성전자도 HBM에 집중하고 있다. 전 공정에서 회로 선폭을 얇게 만드는 '미세화'가 아닌 칩 적층 기술이 요구되는 만큼 후공정의 중요성이 커지고 있다. 삼성이 요코하마에 반도체 개발 거점을 신설하는 것도 일본 소재업체와 협력을 강화해 HBM 기술을 확보하기 위한 목적이다.

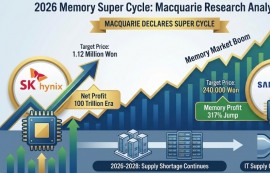

주식시장에서는 AI 반도체 특수를 누리는 엔비디아와 함께 SK하이닉스의 주가도 상승하고 있다. 국내 증권업계에서는 "AI 시대 HBM 수요 확대로 스마트폰 보급기와 같은 시황 부양 효과를 기대할 수 있다"는 목소리가 커지고 있다.

노정용 글로벌이코노믹 기자 noja@g-enews.com

![[일본증시] 닛케이평균 반락 속 반도체·메모리주 급등...키옥시...](https://nimage.g-enews.com/phpwas/restmb_setimgmake.php?w=80&h=60&m=1&simg=2025100107443406877fbbec65dfb210178127232.jpg)