HBM 빅3= SK하이닉스 · 삼성전자 ·마이크론

이미지 확대보기

이미지 확대보기인공지능 먹이사슬 구조를 보면 데이터센터(IDC)= MS 아마존, 구글 (알파벳) , AI 네트워크= 브로드컴 소프트뱅크, AI 서버= SMCI , HP, 델, 지능및 교육모델 개발 =올트먼 (오픈 AI), GPU 설계= ARM 엔비디아 AMD 퀄컴, 파운드리= TSMC 삼성전자, 그리고 HBM 반도체=SK하이닉스 브로드컴 등으로 분석할 수 있다. 이 먹이 사슬에서 GPU 반도체는 마치 바늘의 실 처럼 HBM반도체와 함께한다. 인공 지능을 움직이는 메인 반도체는 GPU 이지만 이 GPU 가 제대로 작동하기위해서는 메모리인 HBM도 반드시 함께 따라 가야 한다. 인공지능 시대에 GPU와 함께 HBM이 뜨는 이유이다,

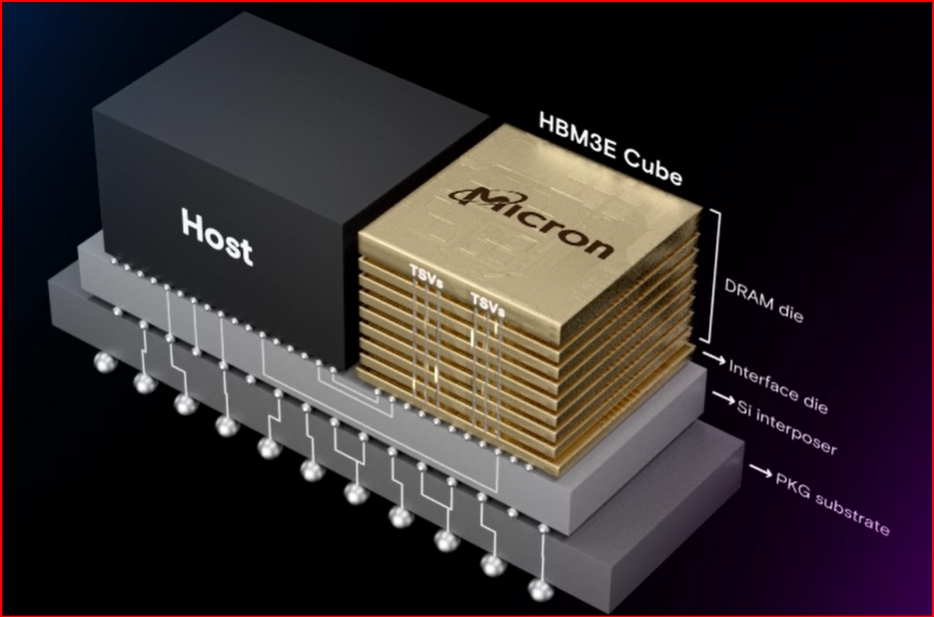

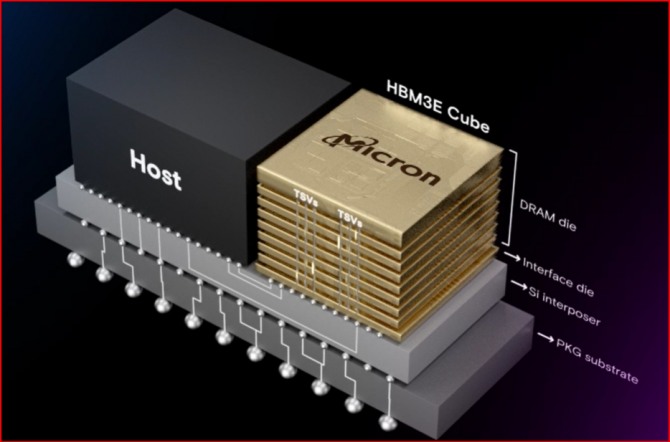

HBM은 영어 High Bandwidth Memory의 약어이다. 우리말로는 흔히 고대역폭 메모리로 번역하고 있다. 고성능 그래픽스 가속기와 네트워크 장치와 결합하기 위해 주로 사용된다. HBM을 채용한 최초 장치는 AMD의 피지 GPU이다. 고대역 메모리 HBM은 JEDEC에 의해 2013년 10월 산업 표준으로 채택되었다. HBM은 DDR4 또는 GDDR5보다 상당히 작은 폼 팩터를 갖추면서도 전기를 덜 사용하는 고대역을 달성한다. 여러 개의 DRAM 다이를 적층함으로써 완성된다. 메모리 컨트롤러를 갖춘 선택적 베이스 다이(base die)들이 이 적층에 들어간다. 베이스 다이(base die)는 실리콘관통전극(TSV)과 마이크로범프(microbump)에 의해 서로 연결된다. HBM은 이 같은 방식으로 GPU의 처리 속도를 획기적으로 높인다. D 램을 단순하게 여러 개 연결하는 것에 비해 공간의 경제성을 크게 제고한다. 전기 사용도 줄이게 된다.

HBM반도체를 만드는 기업으로는 SK하이닉스와 삼성전자 그리고 마이크론 등이 있다. 그중 SK 하이닉스의 매출 비중이 가장 높다. 그 다음이 삼성전자 그리고 마이크론등의 순이다 .SK하이닉스와 삼성전자 그리고 마이크론 등 세 회사가 HBM반도체 패권을 둘러싸고 삼국지 전쟁을 벌이고 있다. 최근까지만 해도 SK 하이닉스가 HBM반도체 매출 점유율에서 단연 선두였다. 가장 먼저 시장한 선점 효과를 누린 것이다. 여기에 마이크론이 도전장을 냈다. 미국 마이크론이 최근 인공지능(AI) 메모리로 수요가 폭발적으로 증가하고 있는 5세대 고대역폭메모리인 ‘HBM3E’ 양산을 시작했다고 선언했다. HBM 시장 선두주자인 SK하이닉스보다도 한발 빠르게 양산에 성공하면서 인공지능(AI) 메모리 시장 구도에 지각 변동을 일으킬 것으로 보인다. 삼성전자, SK하이닉스도 올해 상반기 중 양산에 나선선다. 반도체는 다른 어떤 제품보다 선점 효과가 큰 만큼 5세대 고대역폭메모리 ‘HBM3E’ 양산을 먼저 시작한 마이크론이 앞으로 상당한 위력을 발휘할 것으로 보인다.

마이크론의 시장 진입은 SK하이닉스가 양분하고 있는 HBM 시장에 적잖은 영향을 줄 것으로 관측된다. HBM 시장 초기 마이크론은 HBM과 기술 표준이 다른 HMC(Hybrid Memory Cube)를 내세웠지만 엔비디아를 위시한 다수의 기업들이 HBM을 채택하기 시작하면서 한동안 기술 경쟁에서 밀려있었다. HMC 사업을 접고 다시 HBM에 집중하기 시작한 마이크론은 ‘시장 진입이 늦었다’는 불리한 평가 속에서도 차세대 제품인 HBM3E 개발에 전력투구 해왔다. 수많은 팹리스(반도체 설계전문 기업)과 적극적인 협력을 바탕으로 빠르게 HBM 기술 수준을 높여온 것이다. 마이크론의 HBM 시장 본격 참전은 그동안 한국산이 주류로 자리매김해온 AI 메모리 시장에 많은 영향을 미칠 것으로 보인다. 특히 미국 본토에 팹리스를 비롯해 최종 소비자인 빅테크 기업들과의 파트너십을 맺기에 더 유리한 지위에 있다는 점이 마이크론에 큰 장점이다.

이런 가운데 삼성전자가 업계 최초로 36GB(기가바이트) HBM3E(5세대 HBM·고대역폭메모리) 12H(12단 적층) D램 개발에 성공했다고 발표했다. 삼성전자도 앞으로 HBM 시장 주도권 잡기에 적극 나선다는 선언이다. 'HBM 선두'인 SK하이닉스는 HBM3E 8단 제품을 지난해 8월 개발해 올 상반기 중 양산 계획을 밝힌 바 있다.마이크론도 HBM3E 대량 생산 계획을 공개해 그야말로 HBM 삼국지 패권 전쟁을 연상케 하고 있다. 이다.

삼성전자는 24GB D램 칩을 TSV(실리콘 관통 전극) 기술로 12단까지 적층해 업계 최대 용량인 36GB HBM3E 12H를 구현했다고 밝혔다. HBM3E 12H는 초당 최대 1280GB의 대역폭과 현존 최대 용량인 36GB을 제공해 성능과 용량 모두 전작인 HBM3(4세대 HBM) 8H(8단 적층) 대비 50% 이상 개선한 제품이다. 삼성전자는 인공지능(AI) 서비스 고도화로 데이터 처리량이 급증하는 상황 속에 AI 플랫폼을 활용하는 다양한 기업들에게 이 HBM이 최고의 솔루션이 될 것이라고 밝혔다. 삼성전자는 특히 성능과 용량이 증가한 이번 제품을 사용할 경우 GPU 사용량이 줄어 기업들이 총 소유 비용(TCO)을 절감할 수 있는 등 리소스 관리를 유연하게 할 수 있다고 자랑하고 있다. 서버 시스템에 HBM3E 12H를 적용하면 HBM3 8H를 탑재할 때보다 평균 34% AI 학습 훈련 속도가 향상된다. AI 추론의 경우에도 최대 11.5배 더 많은 사용자 서비스가 가능하다. 삼성전자는 HBM3E 12H 샘플을 엔비디아를 포함한 고객사에게 제공하기 시작했고, 올 상반기 양산할 계획이다.

SK하이닉스도 올 상반기 HBM3E 양산에 적극 뛰어든다. 곽노정 SK하이닉스 사장은 대한상공회의소에서 열린 '민·관 반도체 전략 간담회'에 참석, HBME3 양산 시기에 대해 "올 상반기 중"이라고 언급하며 기존 계획에 변함이 없다고 밝혔다. SK하이닉스는 지난해 4월 업계 최초로 12단 24GB를 구현한 HBM3(4세대) 개발에 성공했다. 1월부터 초기 양산 중인 5세대 제품 HBM3E는 가까운 시일 내 고객사 인증을 마치고 본격 양산에 돌입한다.

1981년 첫 번째 웨이퍼 제조설비 ("팹 1")를 완성했다. 그 공장에서 마이크론은 64킬로 비트 디램칩을 생산하였다. 두 번째 "팹"은 1984년 후반에 완공했다. 거기서는 256킬로비트 디램칩을 생산하였다. 저비용 제조에 집중했기 때문에, 마이크론은 많은 경쟁사가 산업을 폐쇄하던 디램 시장의 폭락에서 생존하였다. 1985년에 위기가 닥쳤다. 당시 일본산 덤핑으로 디램가격이 폭락하였고 디램의 발명기업인 인텔은 아예 디램 시장에서 철수했다. 마이크론은 미국 기업 중에 유일하게 살아남았다. 1998년에 경쟁사 텍사스 인스트루먼트의 메모리 사업을 인수했다. 2001년에 일본 도시바의 메모리 사업을 인수하였다.

1994년에 설립자 조 파키슨이 최고경영자에서 물러났고 스티브 애틀턴이 올랐다. 그는 2012년 2월 3일 비행기 조종 중에 사고로 사망했다. COO 출신인 마크 더칸이 CEO를 이었다. 1990년 초반마이크론 테크놀로지는 개인용 컴퓨터를 제조하는 마이크론 컴퓨터를 설립하였다. 마이크론이라는 브랜드로 컴퓨터를 판매하였다. 1998년 마이크론 테크놀로지는 3차원 컴퓨터 그래픽 칩을 생산하는, 렌디션을 인수하였다. 마이크론 테크놀로지의 인터넷 사업의 제어, 마이크론 인터넷 서비스는 1999년에 마이크론 일렉트로닉스로 편입되었다. 2001년 컴퓨터 제조와 인터넷 사업부를 분리했다. 인터넷 사업부는 웹닷컴으로 기업이름을 변경한 인터랜드 사와 합병되었다. 이후 마이크론 테크놀로지와 관계가 끊어졌다. 컴퓨터 제조 운영부서는 골 테크놀로지 그룹에 매각되었다. 매각된 컴퓨터 제조 부서는 마이크론PC에서 "MPC 컴퓨터"로 브랜드를 변경했다.

2011년 도호쿠 대지진을 거치면서 일본 최후의 DRAM 제조 기업이었던 엘피다 메모리가 4천억엔이라는 막대한 부채를 떠안고 파산하자, 이를 인수해 몸집을 키웠다. 엘피다 메모리는 이후 마이크론 메모리 재팬이라는 마이크론의 자회사가 됐다. DRAM 생산 공장은 히로시마, 설계센터는 카나가와현의 사가미하라시에 위치해있다. 지금은 DRAM 메모리 시장에서 삼성 - SK하이닉스와 함께 빅3를 형성하고 있다. 2017년 중국의 롱시스(Longsys)에 과거에 인수했던 Lexar의 제품군과 생산 시설을 매각했다. 2022년 아이다호 주 보이시에 150억 달러를 투자해서 메모리 반도체 공장을 건설하고 있다. . 2025년 가동 예정이다. 그동안 아이다호 주에는 양산 공장은 없었고 제조공정을 테스트하기 위한 시범 라인이 하나 있을 뿐이었다. 이 공장이 완공되면 엄청난 규모의 생산시설이 창업 반세기만에 본사에 들어서게 된다.

마이크론은 2022년 10월 뉴욕주 오논다가 카운티에 20년간 무려 1000억 달러를 투자하여 대규모 메모리 반도체 공장을 설립하겠다고 발표하였다. 창사 이래 최대 규모의 투자이다. 이 공장은 2024년중 완공된다. 최근 2024년 1분기 실적 발표에서 컨센선스를 상회하는 재무정보와 긍정적인 2024년 가이던스를 내면서 주가가 급등했다. 2024년 설비투자액은 최대 80억 달러로 전년도 대비 소폭 높은 액수다. HBM3E 샘플 배송이 시작되었으며, NVIDIA GH200 인증의 마무리 절차를 짓고 있다며 강조했다. 미국 상무부는 마이크론의 콜로라도, 오레건 공장에 각각 9,000만달러와 7,200만 달러의 인센티브를 지급하겠다고 밝혔다. 투입된 자금의 상당수는 MCU 제작에 쓰일 예정이다.

다음은 마이크론 HBM3E 양산 시작 발표 전문

Micron Commences Volume Production of Industry-Leading HBM3E Solution to Accelerate the Growth of AI

Micron HBM3E helps reduce data center operating costs by consuming about 30% less power than competing HBM3E offerings

BOISE, Idaho, Feb. 26, 2024 (GLOBE NEWSWIRE) -- Micron Technology, Inc. (Nasdaq: MU), a global leader in memory and storage solutions, today announced it has begun volume production of its HBM3E (High Bandwidth Memory 3E) solution. Micron’s 24GB 8H HBM3E will be part of NVIDIA H200 Tensor Core GPUs, which will begin shipping in the second calendar quarter of 2024. This milestone positions Micron at the forefront of the industry, empowering artificial intelligence (AI) solutions with HBM3E’s industry-leading performance and energy efficiency.

HBM3E: Fueling the AI Revolution

As the demand for AI continues to surge, the need for memory solutions to keep pace with expanded workloads is critical. Micron’s HBM3E solution addresses this challenge head-on with:

Superior Performance: With pin speed greater than 9.2 gigabits per second (Gb/s), Micron’s HBM3E delivers more than 1.2 terabytes per second (TB/s) of memory bandwidth, enabling lightning-fast data access for AI accelerators, supercomputers, and data centers.

Exceptional Efficiency: Micron’s HBM3E leads the industry with ~30% lower power consumption compared to competitive offerings. To support increasing demand and usage of AI, HBM3E offers maximum throughput with the lowest levels of power consumption to improve important data center operational expense metrics.

Seamless Scalability: With 24 GB of capacity today, Micron’s HBM3E allows data centers to seamlessly scale their AI applications. Whether for training massive neural networks or accelerating inferencing tasks, Micron’s solution provides the necessary memory bandwidth.

“Micron is delivering a trifecta with this HBM3E milestone: time-to-market leadership, best-in-class industry performance, and a differentiated power efficiency profile,” said Sumit Sadana, executive vice president and chief business officer at Micron Technology. “AI workloads are heavily reliant on memory bandwidth and capacity, and Micron is very well-positioned to support the significant AI growth ahead through our industry-leading HBM3E and HBM4 roadmap, as well as our full portfolio of DRAM and NAND solutions for AI applications.”

Micron developed this industry-leading HBM3E design using its 1-beta technology, advanced through-silicon via (TSV), and other innovations that enable a differentiated packaging solution. Micron, a proven leader in memory for 2.5D/3D-stacking and advanced packaging technologies, is proud to be a partner in TSMC’s 3DFabric Alliance and to help shape the future of semiconductor and system innovations.

Micron is also extending its leadership with the sampling of 36GB 12-High HBM3E, which is set to deliver greater than 1.2 TB/s performance and superior energy efficiency compared to competitive solutions, in March 2024. Micron is a sponsor at NVIDIA GTC, a global AI conference starting March 18, where the company will share more about its industry-leading AI memory portfolio and roadmaps.

About Micron Technology, Inc.

We are an industry leader in innovative memory and storage solutions transforming how the world uses information to enrich life for all. With a relentless focus on our customers, technology leadership, and manufacturing and operational excellence, Micron delivers a rich portfolio of high-performance DRAM, NAND and NOR memory and storage products through our Micron® and Crucial® brands. Every day, the innovations that our people create fuel the data economy, enabling advances in artificial intelligence and 5G applications that unleash opportunities — from the data center to the intelligent edge and across the client and mobile user experience. To learn more about Micron Technology, Inc. (Nasdaq: MU), visit micron.com.

© 2024 Micron Technology, Inc. All rights reserved. Information, products, and/or specifications are subject to change without notice. Micron, the Micron logo, and all other Micron trademarks are the property of Micron Technology, Inc. All other trademarks are the property of their respective owners.

김대호 글로벌이코노믹 연구소장/ 경제학 박사 tiger8280@g-enews.com