메르세데스-벤츠 신형 CLA, 미국 1분기·유럽 2분기 출시

중국 딥시크 R1 성과 인정…"오픈소스 모델 성능 격차 빠르게 축소"

중국 딥시크 R1 성과 인정…"오픈소스 모델 성능 격차 빠르게 축소"

이미지 확대보기

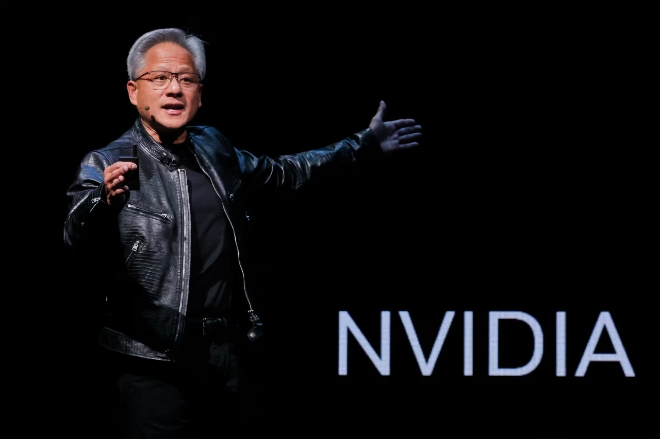

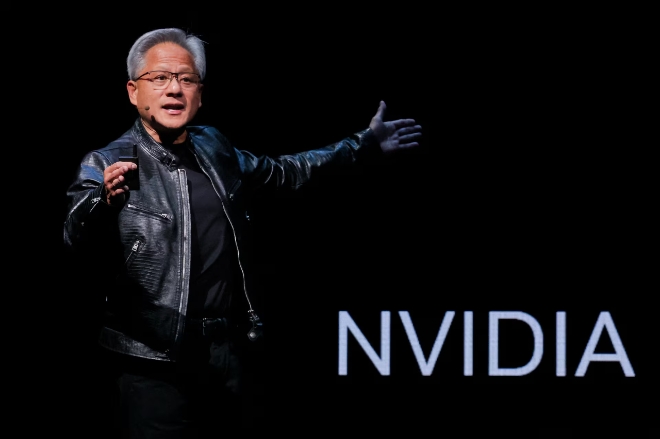

이미지 확대보기디지타임스는 지난 5일(현지시간) 미국 네바다주 라스베이거스에서 열린 'CES 2025'에서 젠슨 황 엔비디아 최고경영자(CEO)가 자율주행 모델 '알파마요'(Alpamayo)와 차세대 컴퓨팅 플랫폼 '베라 루빈'(Vera Rubin)을 공개하며 AI 산업 전방위 확장 전략을 밝혔다고 6일 보도했다.

황 CEO는 컴퓨터 산업이 10~15년마다 주요 플랫폼 전환을 겪는다며, 현재 처음부터 AI 기능을 핵심 구조로 삼아 설계된 'AI 네이티브 애플리케이션'으로의 전환과 GPU(그래픽처리장치) 중심 컴퓨팅으로의 이동이 동시에 진행되고 있다고 강조했다. 특히 황 CEO는 2025년이 추론 AI와 에이전트 시스템이 동시에 확산된 해였다고 평가하며 업계 재편을 예고했다.

추론 AI 경쟁 본격화…중국 딥시크 R1 언급 눈길

황 CEO는 추론 모델을 2026년 AI 업계 핵심 화두로 제시했다. 초기 언어 모델인 버트(BERT)에서 트랜스포머를 거쳐 챗GPT가 대중화 전환점을 만들었다면, 이제는 실시간으로 더 많은 연산을 투입해 '생각'하는 추론 시스템 시대가 열렸다는 설명이다. 그는 이를 AI 모델이 실제 추론(테스트) 단계에서 더 큰 규모로 확장해 성능을 높이는 '테스트 타임 스케일링'(test-time scaling)이라고 표현했다.

주목할 점은 중국 AI 스타트업 딥시크(DeepSeek)의 오픈소스 추론 모델 'R1'을 언급한 대목이다. 황 CEO는 딥시크 R1이 오픈 추론 시스템의 놀라운 촉매제가 됐다며, 오픈소스 모델이 선도 기업 수준의 성능 격차를 빠르게 좁히고 있다고 평가했다. 업계에서는 딥시크 R1이 오픈AI의 'o1' 모델과 대등한 성능을 보이면서도 개발 비용은 95% 가량 적게 들었다고 알려졌다. MIT 라이선스로 공개된 6710억 개 파라미터(매개변수) 규모의 R1 모델은 수학 벤치마크에서 97.3%, 코딩에서 96.3%의 높은 점수를 기록했다.

자율주행 알파마요, 메르세데스 신형 CLA 첫 탑재

엔비디아는 이날 센서 데이터(카메라·라이다·레이더)를 입력받아 차량의 주행 결정(가속·제동·조향)을 직접 출력하는 단일 AI 모델 기반 자율주행 방식인 종단간(end-to-end) 추론 자율주행 모델 '알파마요'를 발표했다. 카메라 입력부터 차량 제어까지 전 과정을 AI가 통합 처리하는 이 시스템은 실제 주행 데이터, 시뮬레이션 환경 '코스모스'(Cosmos)가 생성한 합성 데이터, 사람의 주행 시연을 결합해 학습됐다.

황 CEO는 알파마요가 자신이 의도한 행동과 추론 과정, 주행 궤적을 설명할 수 있다는 점을 강조했다. 이런 설명 가능성은 드문 상황을 작은 구성 요소로 분해해 추론하도록 해 롱테일 주행 시나리오 문제를 해결하는 데 도움이 된다고 설명했다.

메르세데스-벤츠와 협력해 개발한 자율주행 차량은 올해 본격 출시된다. 알파마요를 탑재한 신형 CLA가 미국에서는 1분기, 유럽에서는 2분기부터 순차 도입된다. 안전성 확보를 위해 학습 기반 '알파마요' 스택과 고전적인 자율주행(AV) 스택을 이중으로 구동하는 구조다. 정책과 안전 평가 시스템이 두 스택 중 하나를 선택하는 방식으로 중복성과 다양성을 확보했다. 신형 CLA는 유럽 신차 안전도 평가 프로그램(NCAP) 등급도 획득했다.

차세대 플랫폼 '베라 루빈' 공개…AI 메모리 병목 해소

엔비디아는 급증하는 AI 연산 수요에 대응하기 위해 암흑 물질 이론을 뒷받침한 천문학자 이름을 딴 '베라 루빈' 플랫폼을 선보였다. 대규모 모델 학습, 강화 학습, 테스트 타임 스케일링 등으로 AI 연산 요구량이 폭증하는 상황에서 무어의 법칙 둔화로 칩과 시스템의 극단적 공동 설계가 필요하다는 판단에서다.

베라 루빈은 맞춤형 베라 CPU와 루빈 GPU 6개를 긴밀하게 결합한 아키텍처다. NV링크 스위치 기술로 다수 GPU를 하나의 거대 칩처럼 작동시키며, NVFP4 텐서 코어, 스펙트럼-X AI 이더넷, 커넥트X 네트워킹, 블루필드4 DPU(데이터 처리 장치), 실리콘 포토닉스 기반 이더넷 스위칭 등을 통합했다. 시스템 수준에서도 연산 트레이 재설계, 냉각기 없는 온수 냉각, MGX 표준화 등을 적용했다.

황 CEO는 AI가 대화 내용을 기억하는 작업 메모리인 'KV 캐시'가 GPU 메모리 용량을 넘어서는 새로운 병목 현상이 발생하고 있다고 지적했다. 그는 이 문제를 해결하기 위해 랙 단위로 별도 KV 캐시 저장 공간을 마련하고, 블루필드4 칩이 이를 관리하도록 설계했다고 설명했다. 빠른 연결망을 통해 이 메모리를 GPU 연산 장치 가까이 배치해 데이터 이동 시간을 줄였다는 것이다. 기밀 컴퓨팅 보호 기능과 전력 평활화 기능도 추가해 불필요한 전력 낭비를 줄였다.

황 CEO는 칩과 시스템부터 인프라, 모델, 애플리케이션까지 아우르는 풀스택 AI 기업으로서 엔비디아의 포부를 재확인하며, 다른 기업들이 AI 제품과 산업을 구축할 수 있도록 지원한다는 입장을 밝혔다.

박정한 글로벌이코노믹 기자 park@g-enews.com